|

|

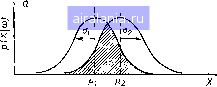

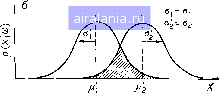

Главная -> Дистанционное зондирование 0 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 [53] 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 правдоподобия. Если задача многомерна, необходимо всего лишь заменить х на вектор X. Интегралы становятся интегралами по объему. На практике необходимо уметь использовать уравнение (1П.26) для вычисления значения вероятности ошибки, подобно тому, как мы вычисляем его по формуле (П1.25) в примере игры в кости. К сожалению, это удается сделать очень редко. Для большинства форм функций плотности, включая нормальную функцию плотности, интегралы в вычислении (П1.26) аналитически не берутся. Если размерность пространства измерений мала, для их вычисления можно использовать численные методы с применением ЭВМ. Но обычно при размерности пространства намного больше единицы этот метод практически нельзя реализовать. Может показаться, что, несмотря на то, что мы имеем метод, позволяющий разрабатывать оптимальный классификатор по максимуму правдоподобия, на практике мы не можем проверить, насколько хороша его «оптимальность», хотя это очень важно знать. Позднее мы увидим, что ситуация не настолько безвыходна. Оценка ошибки по обучающим данным Прежде всего, обучающие выборки, использованные для построения классификатора, могут быть затем сами им классифицированы. Оценка вероятности ошибки для классификатора получается делением числа ошибочно классифицированных точек обучающих данных на общее число классифицируемых точек. Вообще говоря, такая оценка ошибки справедлива только в том случае, если обучающие выборки действительно представляют все множество данных, по,цлежащее классификации. На практике классификация обучающего набора дает обычно оптимистические результаты; вероятность ошибки, оцененная по обучающим данным, оказывается ниже вероятности ошибки для полного множества данных. Ограничения при сборе наземных данных часто препятствуют получению действительно представительных обучающих выборок. И, к сожалению, результаты классификации обучающих выборок не дают реального представления о том, насколько точно обучающие выборки отражают полный набор данных. В лучшем случае мы можем сказать, что классификация обучающих выборок дает нижнюю границу или оптимистический нижний предел истинной вероятности ошибки. Оценка ошибки по контрольным данным Обычно набор данных для точек, которые достаточно точно определены по классам, разбивается на два поднабора. Один поднабор, называемый обучающей выборкой, используется для построения классификатора; другой поднабор предназначен для проверки его работы. Качество работы классификатора на по- следнем наборе данных позволяет сделать другую оценку вероятности ошибки, связанную с классификатором. Как и в случае обучающих выборок, очень важно, чтобы контрольные данные были представительными для полного набора входных данных. В идеальном случае данные, включаемые в контрольный набор, должны выбираться случайным образом со всей области, подлежащей классификации, чтобы избежать различных смещений, нарушающих их представительность. Например, исследователи склонны отбирать для контроля однородные участки данных, не учитывая то, является ли однородность типичной для данной области. Конечно, чем больше контрольный набор, тем больше вероятность того, что он будет достаточно представительным. На практике, к сожалению, существуют ограничения на количество доступных контрольных данных. Одно из них - стоимость их сбора путем наземной проверки или с помощью других средств. Другое, связанное с этим ограничение - необходимость из-за малого числа данных с известной классификацией использовать адекватные данные для обучения классификатора. Оценка качества работы классификатора по контрольным данным не настолько достоверна, как оценка по обучающим данным. Если между этими двумя оценками наблюдается хорошее совпадение, то, с одной стороны, вероятно, что при обучении использовался представительный набор данных. С другой стороны, значительное несоответствие между ни.ми указывает, что один из этих наборов (или оба) недостаточно полно отображает весь набор данных. Косвенные оценки ошибки классификации Заметим, что прямая оценка вероятности ошибки по соотношению (1П.26) обычно затруднена или даже невозможна. Существует несколько способов, позволяющих оценить вероятность ошибки косвенным путем. В следующем разделе мы введем понятие статистической разделимости и покажем, как статистическая разделимость может быть связана с качеством классификатора. Будет определено несколько «индикаторных функций», являющихся мерами статистической разделимости, и показано, как их можно использовать для сравнения качества работы разных вариантов классификатора, а также для получения оценок границ вероятности ошибки. III.8. Статистическая разделимость и отбор признаков Продолжая поиск меры вероятности ошибки классификатора, сконцентрируем внимание на анализе данных, для которого такая мера особенно полезна. Предположим, в частности, что стоимость использования всех доступных каналов многоспектрального сканера в данном приложении дистанционных исследований слишком высока (требуется слишком много вычислений или оборудования) и, кроме того, что разумный выбор не-  которого поднаОора каналов обеспечит достаточную точность классификации*. На каком основании должен делаться выбор каналов? Это - задача, называемая в распознавании образов отбором признаков. Она является частным случаем более общей задачи выделения признаков, которую мы более детально рассмотрим в следующем разделе. Сформулируем задачу I отбора признаков более формально следующим образом. Имеется задача распознавания образов с т классами и N доступными измерениями; найти поднабор измерений, обеспечивающий оптимальное соотнощение между вероятностью ошибки и стоимостью классификации. Рещение этой задачи требует сравнения альтернативных поднаборов измерений на основе оценки качества классификации, которую они могут обеспечить. Лучше всего делать это сравнение, основываясь на вероятности ошибки классификатора, принимая во внимание, конечно, также и стоимость классификации. Но мы уже видели, что вычисление вероятности ошибки часто невозможно, поэтому остановимся на определении возможного индикатора качества классификатора, который будем называть статистичес-показана связь статистичес-   Рис. III. 15. Ошибка меняется в зависимости от «нормализованного расстояния»: а - две перекрывающиеся нормальные плотности, б - увеличение расстояния между математическими ожиданиями уменьшает вероятность ошибки, в - увеличение дисперсии увеличивает вероятность ошибки кой разделимостью. Будет кой разделимости с вероятностью ошибки. Было показано, что вероятность ошибки тесно связана с областью, лежащей ниже функции распределения вероятностей в * В гл. VIII будет показано, что на практике при ограниченном объеме обучающих данных использование дополнительных каналов не всегда ведет к улучшению качества классификатора. Фактически, качество может даже ухудшиться. Причина связана со сделанным ранее наблюдением, что минимальное число точек, необходимых для обучения, является функцией числа каналов (см. разд. П1.5). 168 0 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 [53] 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 0.0122 |